📝

✨AI-900対策ノート:分類モデルの評価指標まとめ 📊

目次

*試験対策用のメモ✍

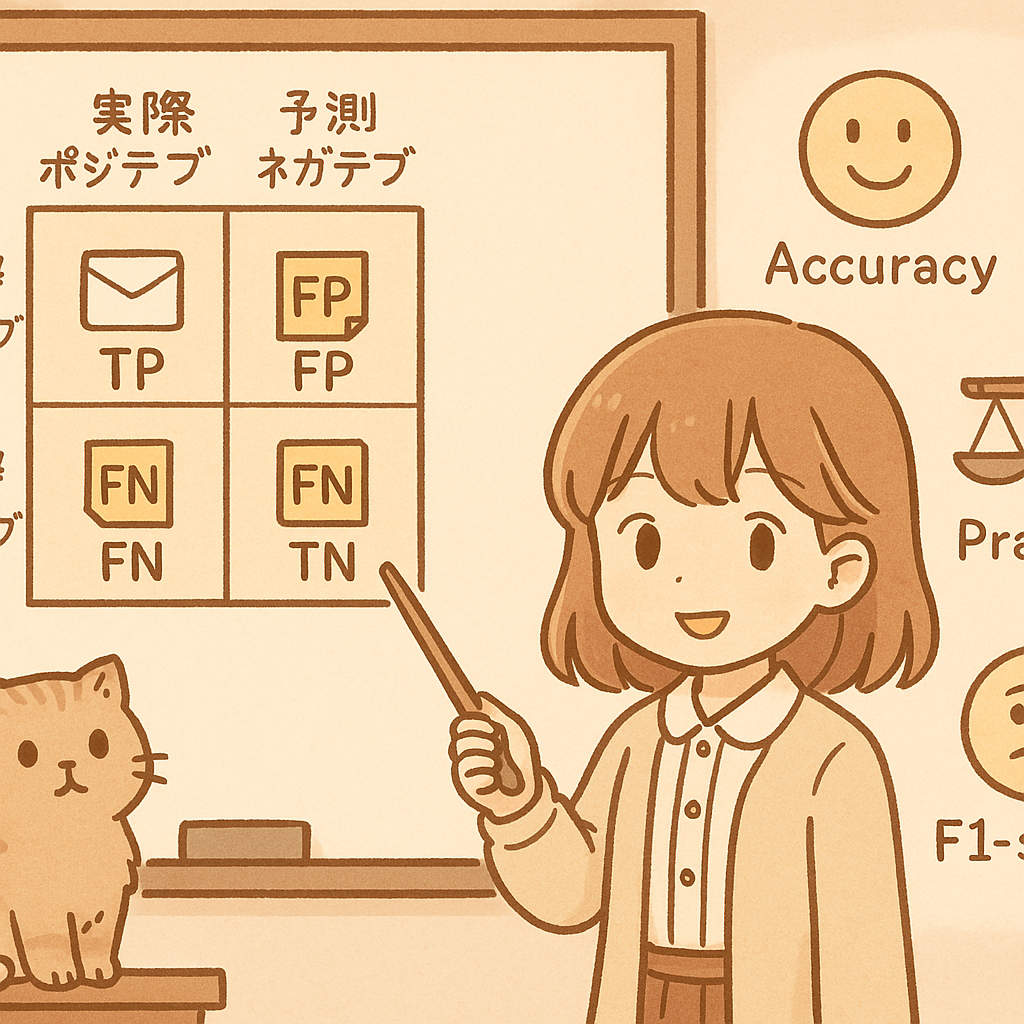

1️⃣ 混同行列ってなに?

「モデルが何を当てて、何を間違えたかを表にしたもの」だよ!正解だったときが対角線上のセルにあらわれるのがポイント

📦 例:スパムメールの判定

| 📬実際スパム | ✉️実際スパムじゃない | |

|---|---|---|

|

🔮予測:スパム |

✅当てた!(TP) | ❌間違えた!(FP) |

| 🔮予測:スパムじゃない | ❌見逃した!(FN) | ✅当てた!(TN) |

2️⃣ 精度(Accuracy)

👀「全部のうち、どれくらい当たった?」

✅正解いっぱい → 高い

🚫クラスがかたよってるときはダマされるかも!

3️⃣ 適合率(Precision)

陽性と予測したものの中で、どれだけ正解?

例:

予測でスパムと判定した50件のうち、実際スパムだったのは40件 →

→ Precision = 40 / 50 = 80%

→ **誤報が少ないか?**に注目したいときに使うよ(例:医療診断で誤って病気と告げたくないとき)

例:普通のメールをスパムにしちゃうのは困る!

4️⃣ 再現率(Recall)

実際に陽性だったもののうち、どれだけ当てられた?

例:

実際スパムだったのは60件、そのうち40件を予測できた →

→ Recall = 40 / 60 = 66.7%

→ **見逃しが少ないか?**を重視するならこれ!(例:ガンの早期発見など)

例:病気の人を見逃すと大変!

5️⃣ F値(F1-score)

⚖️ PrecisionとRecallのバランス点数

どっちも大事にしたいときの仲直りスコア

🎯 どう使い分けるの?

| シーン | 大事なのは? | なぜ? |

|---|---|---|

| 🧬 病気の検査 | Recall | 見逃しちゃダメ! |

| 📩 スパムメール | Precision | 普通のメールをスパムにしちゃダメ! |

| 🤖 全体性能をざっくり見たい | Accuracy | 全体の当てっぷりを見るとき |

| ⚠️ 不均衡データ(陽性が少ない) | F1-score | バランス良く評価したいとき |

🐱 まとめると…

-

Accuracy:ざっくり全部の当たり具合!

-

Precision:当てた中にハズレが多くない?

-

Recall:本物をちゃんと見つけられた?

-

F1-score:そのバランスどうだった?

.png)

💬 コメントしてみる?